As empresas Google, Meta e OpenAI anunciaram nos últimos dias várias medidas que ajudam a identificar imagens ou arquivos que foram produzidos com inteligência artificial (IA), avança o El País.

Em causa está o facto de as empresas acharem que a disseminação de informação falsa pode condicionar os resultados das eleições.

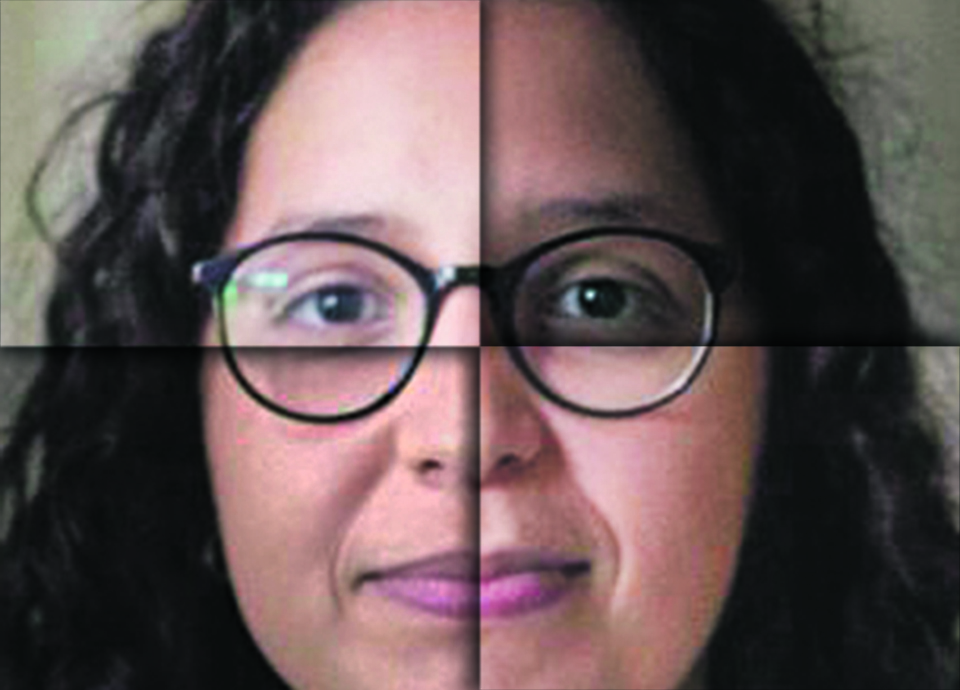

Segundo o jornal, as iniciativas variam entre marcas visíveis nas próprias imagens e mensagens escondidas nos metadados do arquivo ou em pixels gerados artificialmente.

O padrão C2PA, permite

As empresas não deram prazos para a introdução das medidas, contudo, revelam que estão a desenvolver esse recurso e que nos próximos meses "vão começar a aplicar rótulos em todos os idiomas suportados por cada aplicação", afirma Nick Clegg, presidente de relações públicas da Meta.

A Meta promete não apenas marcar visualmente as imagens geradas pelas ferramentas de IA, mas também detetar e identificar as que são publicadas nas suas redes sociais, como o Instagram, Facebook e Threads, sempre que possível.

"Podemos marcar imagens do Google, OpenAI, Microsoft, Adobe, Midjourney e Shutterstock à medida que são implementados metadados às imagens criadas pelas suas ferramentas", diz Clegg, presidente de relações públicas da Meta.

Já a Google vai aplicar os seus metadados ao YouTube. Para a Google, o método construído através do SyinthiD pode conseguir "sobreviver a modificações voluntárias" como "adicionar filtros e alterar cores".

category-label-

category-label-