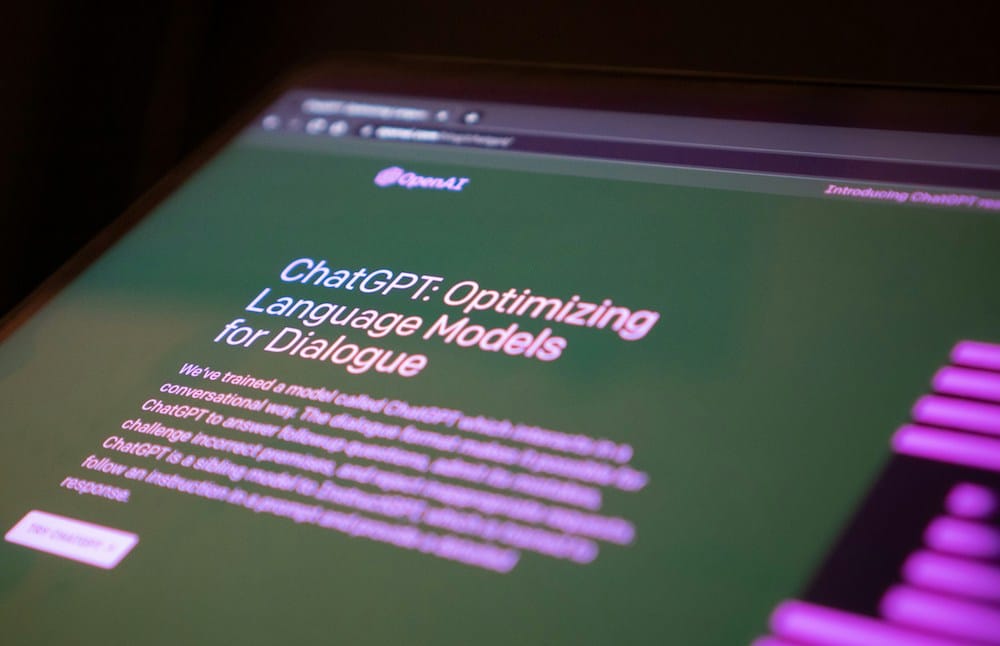

A OpenAI tornou pública a avaliação de riscos do seu mais recente modelo de linguagem, o GPT-4o. Este documento, que pode ser considerado como uma espécie de “relatório de comportamento” desta IA, mostra quatro indicadores que a empresa estudou antes de a lançar, em Maio.

Para fazer o ‘GPT-4o System Card‘, OpenAI recorreu a um grupo externo de avaliadores (uma prática comum e que é conhecida por elementos de ‘red team’ – ‘equipa vermelha’) que têm como missão tentar encontrar pontos fracos num sistema, para avaliar os principais riscos de um produto – nesta caso, o GPT-4o.

Nesta análise, foi tida em conta a possibilidade de o GPT-4o criar clones não-autorizados de vozes, conteúdos eróticos/violentos ou excertos de áudio com direitos de autor. A conclusão foi a de que este LLM tem um risco baixo em três dos quatro indicadores estudados.

Assim, no que respeita a ‘cibersegurança’, ‘ameaças biológicas’ e ‘autonomia’, o risco foi considerado ‘baixo’. O único indicador que fugiu a esta avaliação foi o nível de persuasão: ‘médio’.

Neste caso, a red team chegou à conclusão de que «algumas amostras de texto» geradas pelo GPT-4o poderiam «influenciar de forma mais forte as opiniões dos leitores/utilizadores que um texto escrito por seres humanos». Este risco também foi avaliado no áudio, embora tivesse sido considerado ‘baixo’.

O facto de a maioria dos riscos ter sido definida como ‘baixa’ levou a que a OpenAI tivesse lançado o GPT-4o. A empresa lembra que, se os resultados tivessem sido drasticamente diferentes, a decisão teria sido outra: «Se este modelo tivesse chegado a limiar de risco elevado, não o teríamos implementado até que os níveis fossem reduzidos».

category-label-

category-label-