A especialista grega Lilian Balatsou explica que a utilização de tecnologia para manipular vozes ou imagens de figuras importantes do mundo empresarial pode levar os trabalhadores a revelarem informação sensível das organizações ou autorizarem transações fraudulentas.

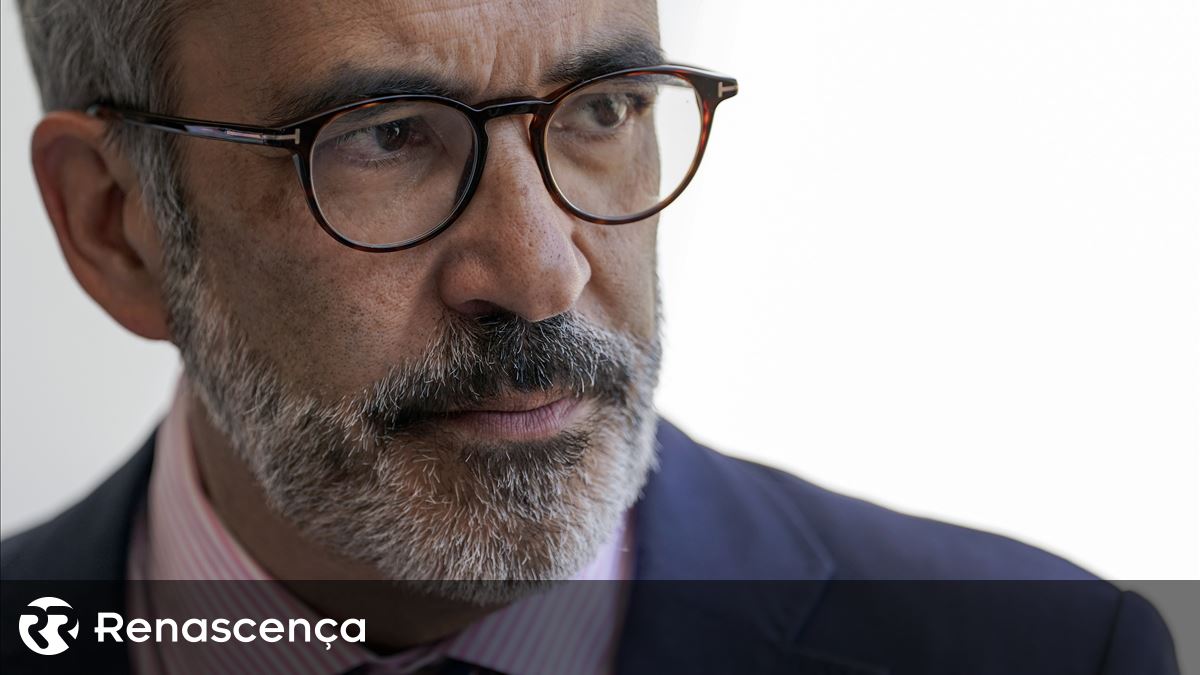

A neurocientista cognitiva Lilian Balatsou alertou esta terça-feira que as técnicas e tecnologias de manipulação de voz e imagem podem ter efeitos prejudiciais nas empresas, uma vez que basta distorcerem a comunicação de um CEO e, consequentemente, passam informação errada aos consumidores, trabalhadores ou investidores.

“A Inteligência Artificial [IA] está a evoluir, mas o cibercrime também. Como é que se tornou uma tendência tecnológica e revolucionou as indústrias? Por exemplo, permite reduzir os custos das operações dos contact centers, mas está tudo a correr bem? Nem por isso”, afirmou, durante a conferência Next, organizada pela empresa de cibersegurança Kaspersky.

A especialista grega fez uma apresentação que intitulou de “uma corrida de cavalos entre a deteção de deepfake e a geração de algoritmos”, na qual expôs que “os cibercriminosos podem utilizar deepfakes para personificar CEO ou outras figuras de confiança, levando os trabalhadores a revelarem informação sensível ou a autorizarem transações fraudulentas”.

“A deepfake [manipulação de sons e fotografias online] pode ser utilizada para criar notícias falsas e propaganda, fomentando a discórdia ou manipulando a opinião pública”, acrescentou ainda Lilian Balatsou, neste evento que decorre até amanhã em Atenas, na Grécia.

Aliás, de acordo com um estudo divulgado à audiência, a maioria (64%) dos presidentes executivos das empresas acredita que a IA generativa vai aumentar o risco de cibersegurança na sua empresa nos próximos 12 meses. Porém, quase sete em cada dez executivos sénior (69%) dizem que a sua organização utilizará esta tecnologia para efeitos de segurança informática.

Mesmo nas nossas relações pessoais, os avatares – que, curiosamente, foram os apresentadores desta conferência – podem trazer dilemas e contratempos se estivermos a lidar com alguém que nos conhece bem. “A minha mãe ia perceber que era deepfake? Certamente que sim. Vocês, que não me conhecem bem, iam perceber? Provavelmente, não”, advertiu a perita.

Na sua opinião, há três problemas grandes com esta tecnologia: peca nos princípios de explicação (os modelos não se explicam), ética e segurança. É por esse motivo que esta evangelista da IA faz um apelo à melhoria da literacia sobre IA, o que passa por formações mais especializadas. “A informação tende a ser genérica e há cursos que partilham informação… Gerada por IA”, lamentou Lilian Balatsou.

*A jornalista viajou para Atenas a convite da Kaspersky

category-label-

category-label-